Быстрое развитие дронов в последние годы открыло различные приложения, включая обнаружение объектов, патрулирование и аэрофотосъемку. Однако, они все еще не могут физически взаимодействовать с объектами для выполнения более сложных операций. Дрон, оборудованный манипулятором с артикулированной рукой, может выполнять такие сложные взаимодействия, как захват и удержание объектов.

В большинстве сред воздушному манипулятору потребуются независимые возможности получения и обработки информации; в частности, разработка визуальной системы, которая может точно и последовательно идентифицировать и локализовать цель, является основным направлением исследований. Исследователи из Нанкинского университета аэронавтики и астронавтики разработали алгоритм визуального распознавания и позиционирования на основе модели обнаружения объектов глубокого обучения YOLOv5 и датчика RGB-D, который способен обнаруживать объекты и оценивать их местоположение в реальном времени во время работы robotic arm.

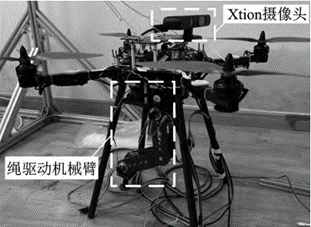

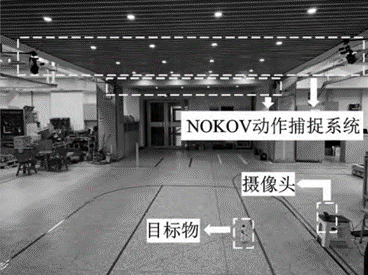

Поскольку существующий роботизированный манипулятор команды не может выполнить полный эксперимент по управлению захватом в полете, исследователи протестировали алгоритм оценки целевого позиционирования в контролируемой indoor-среде с упрощенным экспериментом. Рефлексные маркеры были размещены на камере дрона и целевом объекте; для регистрации позиций маркеров использовалась система захвата движения NOKOV.

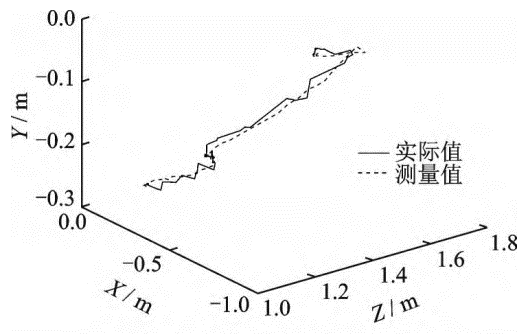

Система захвата движения NOKOV смогла в реальном времени выводить местоположения как камеры, так и цели через мировую систему координат. Поскольку система захвата движения NOKOV достигает точности на уровне субмиллиметров, полученные данные использовались для оценки точности системы визуализации дрона после подгонки облачных данных и преобразования координат. Исследователи перемещали камеру в одном направлении, чтобы смоделировать движение камеры во время полета, тем самым тестируя общую производительность алгоритма позиционирования.

Библиография: